Čo je súbor Robots.txt v doméne?

Nástroje Správcu Webu Webové Stránky Seo Hrdina / / March 19, 2020

Posledná aktualizácia dňa

Jednou z najväčších chýb pre nových vlastníkov webových stránok nie je prehliadanie súboru robots.txt. Čo to vlastne je a prečo je to také dôležité? Máme vaše odpovede.

Ak vlastníte webovú stránku a staráte sa o stav SEO svojho webu, mali by ste sa oboznámiť so súborom robots.txt vo svojej doméne. Verte tomu alebo nie, to je znepokojivo vysoký počet ľudí, ktorí rýchlo spustia doménu, nainštalujú rýchlu webovú stránku WordPress a nikdy sa neobťažujú so svojím súborom robots.txt robiť nič.

To je nebezpečné. Nesprávne nakonfigurovaný súbor robots.txt môže skutočne zničiť stav SEO vášho webu a poškodiť všetky šance, ktoré môžete mať na zvýšenie svojej prevádzky.

Čo je súbor Robots.txt?

robots.txt súbor je vhodne pomenovaný, pretože v podstate ide o súbor, ktorý obsahuje pokyny pre webové roboty (napríklad roboty vyhľadávacích strojov) o tom, ako a čo môžu na vašom webe indexovo prehľadávať. Toto je webový štandard, po ktorom nasledujú webové stránky od roku 1994 a všetky hlavné prehľadávače webu dodržiavajú tento štandard.

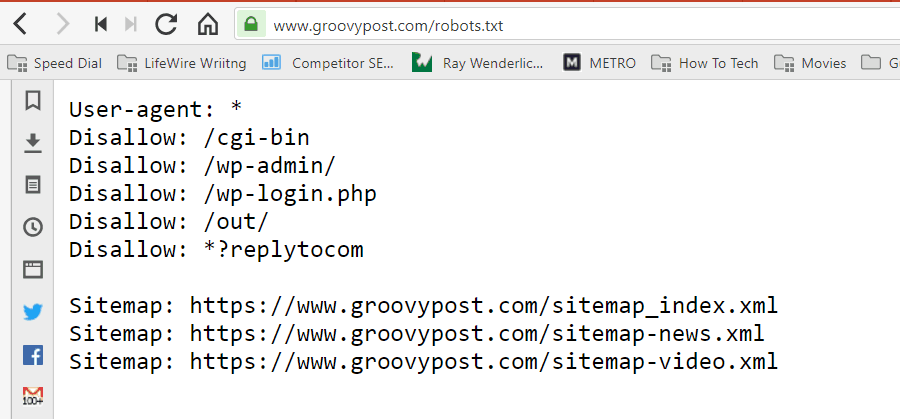

Súbor je uložený v textovom formáte (s príponou .txt) v koreňovom priečinku na vašom webe. V skutočnosti môžete súbor robot.txt ľubovoľného webu zobraziť iba zadaním domény nasledovanej reťazcom /robots.txt. Ak to vyskúšate s groovyPost, uvidíte príklad dobre štruktúrovaného súboru robot.txt.

Súbor je jednoduchý, ale efektívny. Tento vzorový súbor nerozlišuje medzi robotmi. Príkazy sa vydávajú všetkým robotom pomocou User-agent: * smernice. To znamená, že všetky príkazy, ktoré nasledujú, sa vzťahujú na všetkých robotov, ktorí navštívia web, aby ich mohli prehľadávať.

Zadanie webových prehľadávačov

Môžete tiež určiť konkrétne pravidlá pre konkrétne webové prehľadávače. Napríklad môžete povoliť robotu Googlebot (webový prehľadávač spoločnosti Google) prehľadávať všetky články na vašom webe, ale možno budete chcieť zakážte ruskému webovému prehľadávaču Yandex Botovi v prehľadávaní článkov na vašom webe, ktoré obsahujú hanebné informácie Rusko.

Existujú stovky webových prehľadávačov, ktoré vyhľadávajú internet za informácie o webových stránkach, ale tu je uvedených 10 najbežnejších, ktorých by ste sa mali zaujímať.

- Googlebot: Vyhľadávací nástroj Google

- Bingbot: Vyhľadávací nástroj spoločnosti Microsoft Bing

- usrkávať: Vyhľadávací nástroj Yahoo

- DuckDuckBot: Vyhľadávací nástroj DuckDuckGo

- Baiduspider: Čínsky vyhľadávací nástroj Baidu

- YandexBot: Ruský vyhľadávací nástroj Yandex

- Exabot: Francúzsky vyhľadávací nástroj Exalead

- Facebot: Prechádzajúci robot spoločnosti Facebook

- ia_archiver: Alexin webový indexový prehľadávač

- MJ12bot: Databáza indexovania veľkých odkazov

Ak použijeme príklad uvedený vyššie, ak ste chceli povoliť robotovi Googlebot indexovať všetko na vašich stránkach, ale chceli by ste blokovať Yandex v indexovaní obsahu vášho ruského článku, do svojho robots.txt by ste pridali nasledujúce riadky file.

User-agent: googlebot

Disallow: Disallow: / wp-admin /

Disallow: /wp-login.php

User-agent: yandexbot

Disallow: Disallow: / wp-admin /

Disallow: /wp-login.php

Zakázať: / rusko /

Ako vidíte, prvá časť blokuje Google iba prehľadávanie vašej prihlasovacej stránky WordPress a správcovských stránok. Druhá časť blokuje Yandex z toho istého, ale aj z celej oblasti vášho webu, na ktorej ste publikovali články s obsahom proti Rusku.

Toto je jednoduchý príklad toho, ako môžete používať zakázať príkaz na ovládanie konkrétnych webových prehľadávačov, ktoré navštívia vaše webové stránky.

Ďalšie príkazy Robots.txt

Zakázať nie je jediný príkaz, ku ktorému máte prístup v súbore robots.txt. Môžete tiež použiť ktorýkoľvek z ďalších príkazov, ktoré nasmerujú, ako robot môže prehľadávať vaše stránky.

- zakázať: Upozorňuje agenta používateľa, aby sa vyhýbal indexovému prehľadávaniu konkrétnych adries URL alebo celých častí vášho webu.

- dovoliť: Umožňuje doladiť konkrétne stránky alebo podpriečinky na vašom webe, aj keď ste pravdepodobne zakázali nadradený priečinok. Napríklad môžete zakázať: / about /, ale potom povoliť: / about / ryan /.

- Crawl-delay: Toto povoľuje prehľadávaču, aby počkal xx počet sekúnd, než začne indexovo prehľadávať obsah stránok.

- Mapa stránok: Poskytnite vyhľadávacím nástrojom (Google, Ask, Bing a Yahoo) umiestnenie vašich súborov XML.

Majte na pamäti, že roboti budú iba po zadaní názvu robota si vypočujte príkazy, ktoré ste zadali.

Častou chybou, ktorú ľudia robia, je zakázanie oblastí ako / wp-admin / od všetkých robotov, ale potom zadajte časť googlebot a zakazujú iba ďalšie oblasti (napríklad / about /).

Pretože roboti sa riadia iba príkazmi, ktoré určíte v ich sekcii, musíte prehodnotiť všetky ostatné príkazy, ktoré ste zadali pre všetkých robotov (pomocou * user-agent).

- zakázať: Príkaz používaný na upozornenie agenta používateľa, aby neprehľadával konkrétnu adresu URL. Pre každú adresu URL je povolený iba jeden riadok „Zakázať:“.

- Povoliť (platí iba pre Googlebot): Príkaz, ktorý povie robotovi Googlebot, že má prístup na stránku alebo podpriečinok, hoci jej nadradená stránka alebo podpriečinok môžu byť zakázané.

- Crawl-delay: Koľko sekúnd by mal prehľadávač počkať, kým načíta a prehľadá obsah stránky. Upozorňujeme, že robot Googlebot tento príkaz neuznáva, ale rýchlosť prehľadávania môžete nastaviť v službe Google Search Console.

- Mapa stránky: Používa sa na vyvolanie umiestnenia súborov XML sitemap spojených s touto adresou URL. Upozorňujeme, že tento príkaz podporujú iba spoločnosti Google, Ask, Bing a Yahoo.

Nezabudnite, že cieľom súboru robots.txt je pomôcť legitímnym robotom (napríklad robotom vyhľadávacieho nástroja) efektívnejšie indexovo prehľadávať vaše stránky.

Existuje veľa škodlivých prehľadávačov, ktoré indexovo prehľadávajú vaše stránky a robia veci, ako je napríklad škrabanie e-mailových adries alebo ukradnutie vášho obsahu. Ak chcete skúsiť použiť súbor robots.txt na zablokovanie týchto prehľadávačov v prehľadávaní všetkého na vašich stránkach, neobťažujte sa. Tvorcovia týchto prehľadávačov zvyčajne ignorujú všetko, čo ste vložili do súboru robots.txt.

Prečo niečo zakázať?

Pre väčšinu vlastníkov webových stránok je prvoradým cieľom dosiahnuť, aby vyhľadávací nástroj spoločnosti Google indexovo prehľadal čo najkvalitnejší obsah na vašom webe.

Spoločnosť Google však vydáva iba obmedzené výdavky rozpočet na indexové prehľadávanie a rýchlosť indexového prehľadávania na jednotlivých stránkach. Miera indexového prehľadávania predstavuje počet žiadostí Googlebot za sekundu, ktoré na vašu webovú stránku počas udalosti prehľadávania podajú.

Dôležitejší je rozpočet na indexové prehľadávanie, ktorý predstavuje celkový počet žiadostí, ktoré robot Googlebot predloží na indexové prehľadávanie vašich stránok v jednej relácii. Google „vynakladá“ svoj rozpočet na indexové prehľadávanie zameraním sa na oblasti vášho webu, ktoré sú veľmi populárne alebo sa nedávno zmenili.

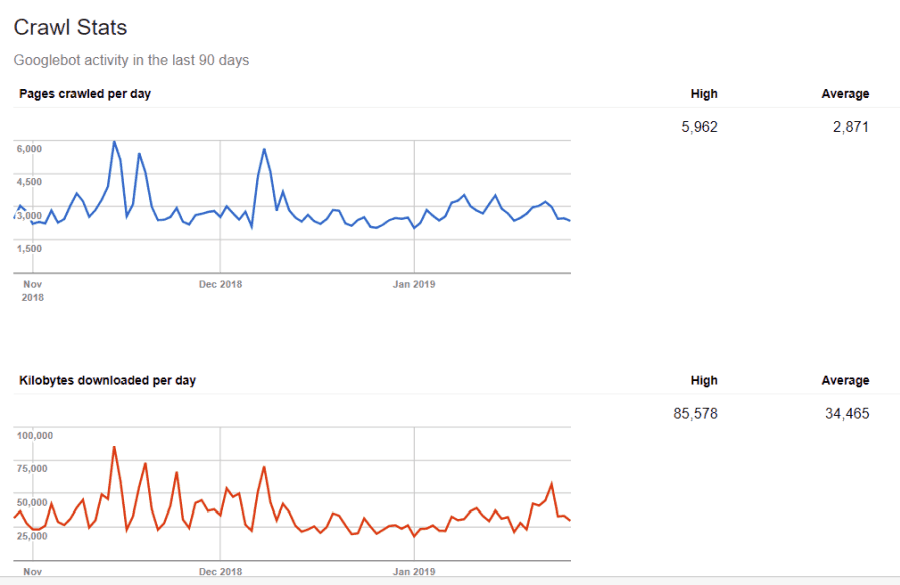

Na tieto informácie nie ste slepí. Ak navštívite Nástroje správcu webu Google, môžete vidieť, ako prehľadávač manipuluje s vašimi webmi.

Ako vidíte, prehľadávač udržiava aktivitu na vašom webe každý deň dosť konštantnú. Neprehľadáva všetky stránky, ale iba tie, ktoré považuje za najdôležitejšie.

Prečo rozhodnúť o tom, čo je na vašom webe dôležité, necháte na robota Googlebot, keď môžete pomocou súboru robots.txt povedať, aké sú najdôležitejšie stránky? Zabránite tak robotu Googlebot, aby strácal čas na stránkach s nízkou hodnotou na vašom webe.

Optimalizácia rozpočtu indexového prehľadávania

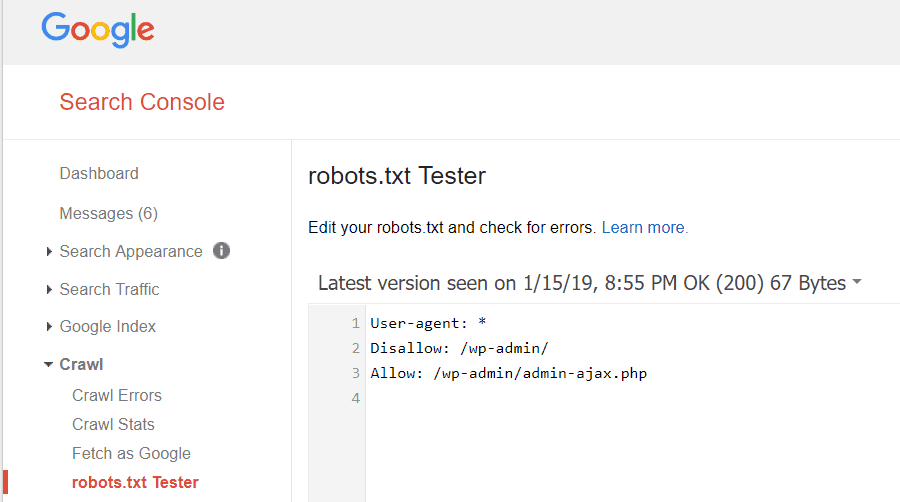

Nástroje správcu webu Google vám tiež umožňujú skontrolovať, či robot Googlebot číta váš súbor robots.txt v poriadku a či sú nejaké chyby.

To vám pomôže overiť, či ste súbor robots.txt správne usporiadali.

Ktoré stránky by ste mali zakázať prehliadaču Googlebot? Pre SEO vašich stránok je dobré zakázať nasledujúce kategórie stránok.

- Duplicitné stránky (napríklad stránky vhodné pre tlač)

- Ďakujeme stránkam, ktoré sledujú objednávky na základe formulára

- Formuláre dopytov k objednávkam alebo informáciám

- Kontaktné stránky

- Prihlasovacie stránky

- „Predajné“ stránky olova s magnetom

Neignorujte svoj súbor Robots.txt

Najväčšou chybou, ktorú vlastníci nových webových stránok robia, je, že sa nikdy nedívají na súbor robots.txt. Najhoršia situácia môže byť v tom, že súbor robots.txt skutočne blokuje váš web alebo jeho časti, aby sa vôbec neprehľadával.

Skontrolujte súbor robots.txt a uistite sa, že je optimalizovaný. Týmto spôsobom Google a ďalšie dôležité vyhľadávacie nástroje „uvidia“ všetky úžasné veci, ktoré na svojom webe ponúkate svetu.